Son 100% viables. También te muestran latencia y demás cosas.

Todo al máximo, a 60 fps.

Tengo un pepino de PC ahora mismo (bueno, pepino para mi que lo corre todo al máximo a 60 fps en 1080. Habrá sibaritas que no lo consideren pepino si no mueve cohetes a 4K y 1000 fps), y vengo de un portatil en el que tenía que jugar a 30 fps con todo al mínimo, así que pienso disfrutarlo jajaja aunque no tenga la máxima ventaja competitiva.

EDIT: Tengo un pepino de PC pero una pantalla del año de la pera porque no ha sido viable de momento pillar otra. Dicha pantalla es a 720 de resolución, 60 Hz, y los colores están ahi ahi. Que hi farem jaja

Yo siempre recomiendo esta guía tanto para configurar las opciones gráficas del juego, como para tener una referencia de la sensibilidad que están usando en la OWL:

Esta guía tiene una explicación detallada de cada parámetro y alguna captura del menú de configuración.

No es que tu monitor vaya a mostrar más FPS. Es que cuantos más FPS genere tu equipo, tu pantalla va a poder mostrar el FPS más cercano a la última acción que realizaste en el juego. Es decir, menos input lag vas a tener.

Esto es algo técnico que se aplica a todos los videojuegos del mundo.

Mención especial para la opción gráfica de “reducir el tamaño del buffer”. Esto permite bajar el input lag significativamente sin tener que desbloquear los FPS máximos. También hay que mencionar que tiene más impacto en monitores de 60 Hz. Si encima la combinas con una buena tasa de FPS, pues consigues reducir aún más el input lag.

Busque unos vídeos que explican este tema y otros en detalle:

No, lo que se produce en ese caso es tearing. Siempre que no estén sincronizadas la GPU y la pantalla vas a tener tearing en mayor o menor medida. No es que se pierdan FPS.

Si, al igual que el Netgraph que también es muy fiable.

No te preocupes, yo tengo un I7 4790 3,6 GHz (no OC, o sea no es k) y una Nvidia GTX 1060 6 gigas, y para mi es un PC MODO DIOS.

jajajajajajajajaja

Todo al maximo de graficos en 1080p, 60FPS con V-Sync y buffer reducido.

Si quito la sincronizacion vertical me sube a 90 o asi creo, no me acuerdo, pero siempre juego con V-Sync activo.

De GPU tengo una RTX 2060.

Todo en Ultra menos 4 cosas… ahora bien, la puñetera neblina no se como quitarla después de 3 años

Sí y no. Lo siento, pero estás mezclando conceptos.

- Uno es el cuadre entre los FPSs generados por tu gráfica y los emitidos por tu monitor. Tu gráfica genera 100 FPSs, pongamos, y tu monitor es de 100 Hz. Lamentablemente tu gráfica los genera dinámicamente (con cambios en la frecuencia, a veces más y a veces menos) y tu monitor emite 100 imágenes por segundo, de forma estable. Así que hay dos factores:

-Lo que tu dices se basa en: Cuanto más genera tu gráfica más posibilidades estadísticas hay de que esté encuadrada con que el monitor emita un fotograma en ése preciso instante. Es matemática básica. A igual frecuencia de muestreo, cuanto mayor sea la frecuencia emitida más fiel será la muestra. Esto es una chapuza, y la fluidez que puedes ganar así, residual. Completamente marginal. Es como comprar más billetes de lotería esperando que así te vaya a tocar.

-Usar tecnologías de sincronización (GSync o FreeSync), que mediante un canal de retorno sincronizan los frames generados y los emitidos.

- Y luego, APARTE, está el input lag. El porcentaje mayor del input lag de un monitor NO es debido a la tasa de refresco. Es debido al tiempo que tarda un monitor en generar una imagen a partir de la información recibida. Es otra métrica (Tiempo de respuesta), aparte de su frecuencia, que podéis encontrar en sus especificaciones. El de un monitor gaming suele ser de 1ms, mientras que el de uno de ofimática suele ir desde los 4ms hasta los 30ms.

De nuevo aclaración ¿La frecuencia influye? Sí. Pero no es lo principal. Mirad los órdenes de magnitud, estamos hablando de milésimas de segundo (ms) en frecuencias que rondan las centenas de hercio (o sea, iteraciones cada centésimas de segundo). Lo que se gana es diez veces superior.

PD Abundan por ahí los “estudios” que avalan que poner FPSs de sobra en un monitor de inferior tasa de refresco es mejor. Se basan en gente que a ciegas, con dos monitores uno al lado del otro, dice cuál le parece que se ve mejor. Huelga decir la CHORRADA con mayúsculas que es esto. Es aplicar metodologías de Ciencias Sociales a la electrónica. La idiotez haciéndose pasar por método.

Es como si para medir potencias de motor pusieras a gente normal a conducir dos coches y les preguntases su opinión, en lugar de usar cálculos y bancos de pruebas. Una majadería.

Residual dices. Perdona pero te remito a los vídeos que te he puesto y a la experiencia de los jugadores profesionales. No solo de Overwatch.

Al igual que todas las guías existentes (que recomiendan lo que te dije). Pero si para ti es residual.

No hace falta que me expliques lo que yo ya se. Yo no soy el que dijo que prácticamente solo importaban los FPS que es capaz de mostrar tu monitor. Te dije que eso no es así, porque suele ser un error muy común pensar eso. Por lógica uno piensa que si su monitor es de 60 Hz, pues todo lo que este por encima de 60 FPS da igual, es tontería. Pero lo cierto es que si importa y tiene un impacto a considerar.

Incluso mayor que el que puede tener jugar con un polling rate en el ratón de 1 ms, a jugar con 8 ms. Si, son solo 7 milisegundos de diferencia, pero tiene impacto en videojuegos competitivos como Overwatch.

Las cuales hay mucha gente que no las usa, salvo que tengas mucho tearing, porque también añaden un ligero input lag (este si se podría considerar residual). Yo personalmente si activaría G-SYNC porque me molesta bastante el tearing.

No estoy hablando ni del input lag del fabricante de un monitor. Ni tampoco de la tasa de refresco. Es el input lag total que tu tienes al jugar un videojuego como Overwatch, que es la suma de múltiples factores.

Claro que hay monitores que tienen 1 ms de tiempo de respuesta de gris a gris, otros tienen 8 ms, otros son IPS con Overdrive. Otros tienen un buen tiempo de respuesta pero un input lag horrible. Pero no hablo de ese tipo de especificaciones del hardware del monitor.

Estoy hablando del lag total que tienes cuando juegas Overwatch. Jugar con la mayor cantidad de FPS posibles reduce este input lag. Independientemente de que tu monitor sea solo de 60 Hz.

La gente nota esa fluidez. Aunque no tanto desde que añadieron la opción de reducir buffer. Si para ti no es considerable esa reducción, limita los FPS y juega como quieras.

Sí, si al final todo se reduce a eso: “Los jugadores profesionales dicen”, “la gente lo nota”, “mucha gente no usa sincronización” etc.

Para mí es irrelevante. Esto es electrónica pura y dura. No una opinión. Tu gráfica emite lo que emite, tu monitor enseña lo que enseña, y la única manera de optimizar ambos al 100% es una tecnología de sincronización como Dios manda. (Que por cierto, no tienen penalización ninguna sobre el rendimiento ya desde hace tiempo). A mi me lo demuestran con números y oye, feliz. Pero si los números no cuadran… las opiniones del resto me importan bien poco, lo siento.

El “venga, generemos más FPSs que así hay más posibilidades de que se emita uno más cercano al que tocaría” y el “no, si yo lo veo más fluído” pues oye… para quien lo vea bien. Que cada uno juegue como quiera, como tú dices.

Y yo también estaba hablando de múltiples factores, pero seamos conscientes de que algunos son diez veces más influyentes que otros. Y luego, de nuevo, que cada uno ignore los que quiera.

Hombre P4dr1n0, pero si que estarás de acuerdo con que existe el rendimiento objetivo, que es el que se mide en cifras y luego el percibido, donde podríamos poner la opinión de los pros.

Si ciertos parámetros dan un mayor rendimiento personal a nivel de resultados en el juego (aim, reacción, etc) aunque no sepan explicar el transfondo tecnológico, saben que funciona mejor de una manera u otra.

Otra cosa es intentar mezclar ambos conceptos. Eso si que no tiene sentido.

Realmente no entiendo porque metes de por medio GSYNC y FreeSync. Estas tecnologías solo tienen una utilidad, que es eliminar el tearing, nada más.

El objetivo de fondo es reducir al máximo el tiempo de respuesta en Overwatch. Eso tiene que ver (entre otras cosas), con la tasa de FPS, no con el hecho de sincronizar la GPU y la pantalla.

Hay mucha gente a la que el tearing no le molesta en absoluto. No es mi caso. Pero técnicamente hablando es otra cosa. Esto va más de la tasa bruta de FPS, independientemente de que estos estén o no sincronizados.

Eso es.

Si hasta tu mismo has reconocido que es un dato basado en la electrónica y no en opiniones. Lo que pasa que para ti la ganancia es marginal, y por eso no le das importancia. Pero aunque sea para ti una mejora insignificante, esa mejora existe y esta basada en datos técnicos, no en opiniones.

Pero es que encima en cualquier guía, en cualquier stream de un jugador profesional, en cualquier análisis técnico… Etc. Se suele recomendar desbloquear los FPS a la cifra más alta (estable), que sea capaz de producir tu equipo.

Precisamente por como funciona la electrónica es por lo que se recomienda hacer eso. No por las opiniones de la gente.

En cualquier caso, si para ti no supone una mejora palpable. Pues deja los FPS limitados, eso si, yo lo comento para quien quiera sacarle el máximo rendimiento competitivo a su equipo, vía configuración gráfica.

Correcto, estoy de acuerdo. Pero una cosa es objetiva y mesurable mediante métricas. Y la otra es una cuestión de sensaciones. Yo (de nuevo tema personal) ignoro las “sensaciones” si no van respaldadas por hechos palpables. Creo que es ahí donde diferimos, parece.

Es que la definición de tearing es precisamente “El efecto que se produce por la desincronización entre la frecuencia de la gráfica y la del monitor” que es la cuestión principal, o al menos eso era lo que creía.

Yo en ningún momento he dicho eso. Y me da la sensación de que o yo no me expreso bien, o tú no me entiendes. Porque por lo que entiendo (puede que no bien) tú mismo te estás contradiciendo en el mismo mensaje (las partes en negrita)

Si lees mi mensaje de arriba mi argumento no se basa en otra cosa que en números (centésimas de segundo contra milésimas de segundo), o una sincronización controlada VS una aproximación puramente estadística.

Acepto que vosotros déis más valor a las impresiones concretas de pros o de usuarios, a videos de YouTube o “las recomendaciones”, que yo, que me limito a las métricas numéricas de rendimiento y a la ponderación de su influencia sobre el total, pero no tergiverses mis palabras, haz el favor.

Te he dicho que el tema no va de tearing. Más de una vez.

Si lo has dicho. Te cito de tu post anterior.

Según tu es residual esa ganancia, pero reconoces su lógica técnica y matemática, por tanto no es una opinión. Que para ti la ganancia es marginal, pero ahí la tienes.

No merece la pena seguir con esto. Buscas discutir por discutir sobre algo que no va a ningún sitio.

El tema no va de lo que tú quieras, lo siento.

Y ése “según tú” implica que es una especie de opinión personal. No lo es. Revisa la lógica y los números. Si algo es de un orden de magnitud mucho más pequeño que otra cosa, es marginal con respecto a ella. No es una opinión. No es “según yo”. Es un hecho.

Y si no lo es, arguméntame por qué. Y si no, efectivamente es tontería discutir por discutir. Buenas tardes.

Segun lo que dice aqui:

https://www.blurbusters.com/faq/benefits-of-frame-rate-above-refresh-rate/

No se quien querria eso…

Es como si fuera escaneo interlineado pero hecho con escaneo progresivo, es la mayor M que he visto nunca xD.

Lo he probado, me he cambiado los graficos para ir a 300 fps y yo no noto esos cortes… (tearing digo).

El artículo que has puesto es bastante bueno. Explica todo de manera bastante clara y concisa. Recomiendo a todo el mundo que le interese el tema que le eche un vistazo, merece la pena.

Hay varias razones para que notes más o menos el tearing. En el punto 3 de el artículo que has puesto, te explican varias de estas razones:

VSYNC OFF during 150fps creates more visible tear lines than 500fps. This is because the horizontal offsets at the tearline boundaries are much smaller at ever higher frame rates.

At ultra-high frame rates, there are many more tear lines, but they are all at smaller offsets:

Also, microstuttering become reduced at higher frame rates, since there’s less harmonic frequency effects between frame rate and refresh rate. 61fps at 60Hz will have 1 stutter per second, as will 145fps at 144Hz. Running at frame rates much higher than refresh rate, massively reduces microstutters caused by harmonics between fps and Hz. This is important during unsynchronized frame rates (VSYNC OFF, Fast Sync, low-lag triple-buffered modes, etc.)

En realidad lo ideal es no tener tearing. Pero muchos jugadores prefieren sacrificar un poco de calidad visual por ganar ese extra de tiempo de reacción. Esto es algo muy subjetivo de cada persona y del equipo que tenga.

Pero bueno si es que pone todo lo que he tratado de decir en mis anteriores post, en ese artículo, por supuesto que mejor explicado de lo que yo lo hice, y además con datos.

Incluso ese detalle que comente en otro post también lo dice:

The disadvantage, however, is tearing during VSYNC OFF. This disadvantage doesn’t matter to many competitive/eSports players where winning the frag is more important.

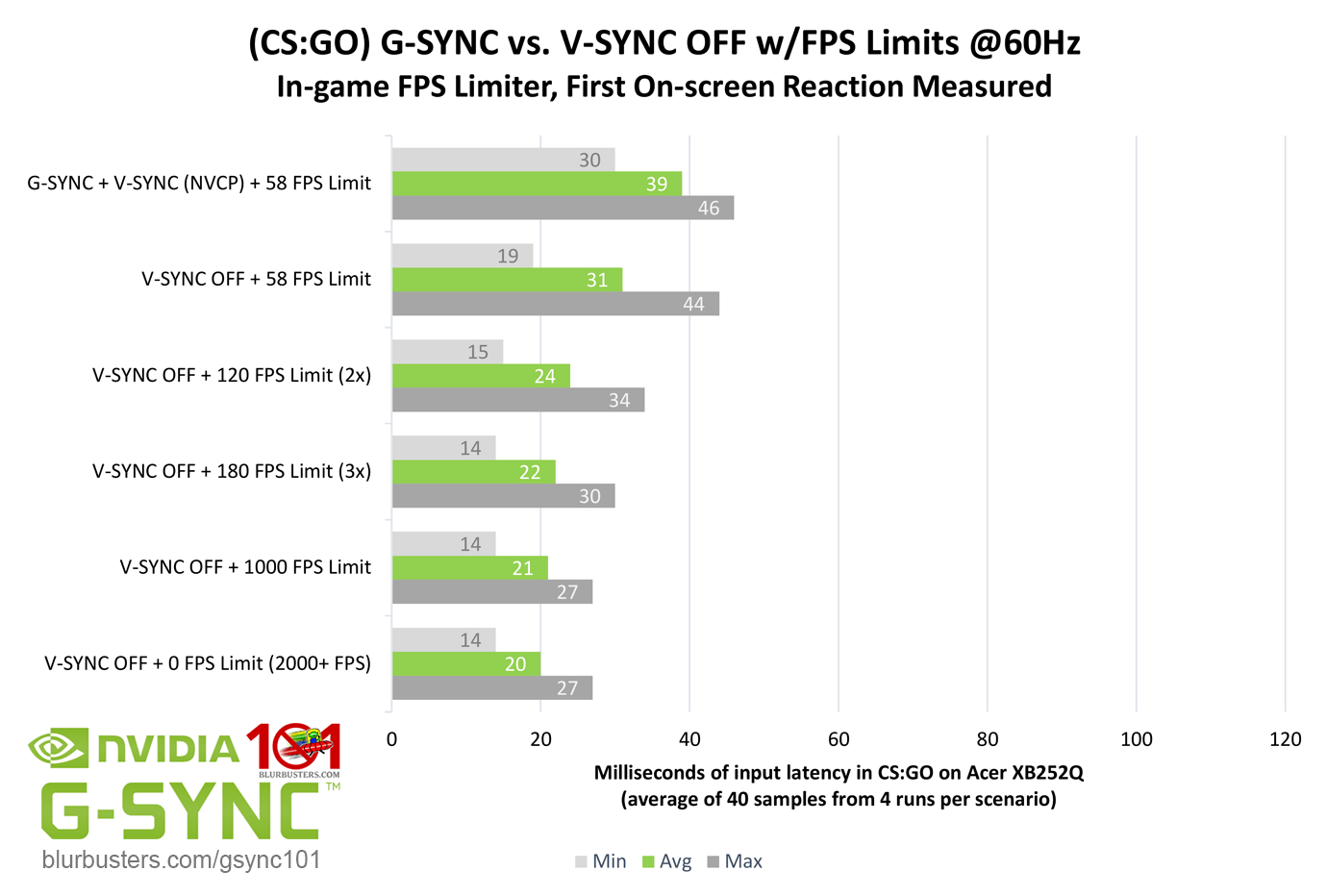

Las ganancias también son bastante importantes si comparamos entre V-SYNC OFF + 58 FPS y VSYNC OFF +180 FPS. Que sería el promedio más parecido a un caso típico de un jugador de Overwatch que pone todo al mínimo.

-5 ms Min.

-9 ms Avg.

-14 ms Max.

Las cifras en Overwatch son diferentes pero basta para hacerse una idea de la ventaja que supone.

De 60 FPS a 300 FPS es una diferencia considerable.

Como ya dije en otro post, tiene incluso más impacto que el polling rate del ratón.